Nos últimos anos, têm se popularizado bastante chats de inteligência artificial como o ChatGPT, o Gemini e o Claude. Eles mudaram de forma significativa, a maneira como as pessoas fazem diversas atividades — como programar, fazer dever de casa, escrever, etc. —, seja pra melhor ou pra pior.

Apesar disso, a maioria dos modelos de IA que se popularizaram são fechados: rodam em um software fechado em um servidor fechado — não rodam nativamente em seu computador, e sim mandam sua mensagem para um servidor que a processa e retorna o resultado.

Entretanto é possível de forma bem fácil rodar modelos de IA nativamente em seu computador por meio do Ollama, uma ferramenta escrita em Go para manusear e rodar LLMs. Entretanto, esteja ciente que, sem um computador bom, não dá pra rodar os melhores modelos, mas dá pra brincar com os mais simples.

Para isso, a primeira coisa que deve ser feita é instalar o Ollama. Para isso, você pode usar o instalador oficial, compilar pela fonte ou instalar pelo gerenciador de pacotes de sua distro Linux. No caso do Fedora:

sudo dnf install ollama Depois de instalado, rode o servidor do Ollama. Para isso, é só digitar no terminal:

ollama serve E para rodar um modelo, digite:

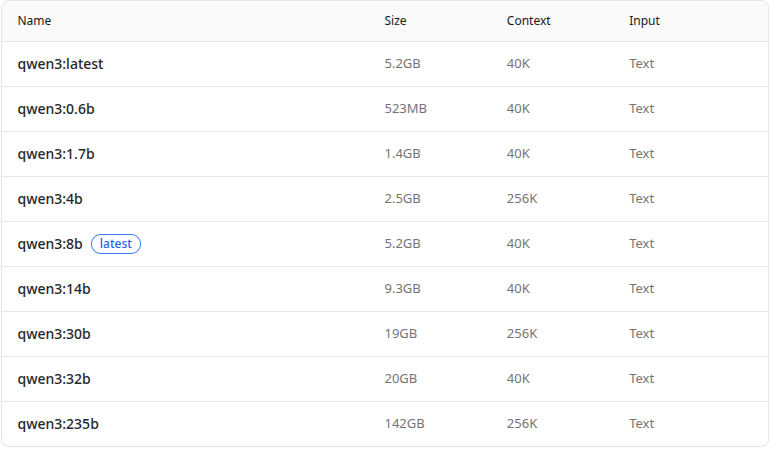

ollama run <nome do modelo> Existem diversos, como DeepSeek e o GPT-OSS. Entretanto, em uma máquina mais fraca e sem placa de vídeo dedicada, os modelos maiores não vão rodar, por isso busque sempre por modelos com poucos parâmetros — por exemplo, nos modelos do Qwen3:

Vemos que são vários. Esse ‘b’ é bilhões de parâmetros, então o qwen3:8b tem 8 bilhões de parâmetros, e o qwen3:0.6b tem 600 milhões de parâmetros. Para rodar um modelo grande é necessário não só uma placa de vídeo boa, mas também muita VRAM. Os modelos menores, de até 4 bilhões, são possíveis de rodar usando a CPU.

Em meus testes, os melhores modelos são o Qwen3, o Gemma3 e o LLaMA 3.2. Eles são pequenos mas podem ser úteis de certa forma. Outros modelos como o Deepseek R1 em seus modelos mais básicos cometem muitos erros e nem conseguem falar português direito.

Para, por exemplo, rodar o Gemma3 de 1 bilhão de parâmetros faria assim:

$ ollama run gemma3:1b

>> Olá, como está?

Olá, estou bem, obrigado por perguntar! Como vai você? 😊

E você, como está? Em que posso ajudar? Para listar, use ollama list, e para apagar, use ollama rm <modelo>.

Como rodar no celular

Para rodar no celular, instale o Termux — que é um terminal Linux dentro do Android de código aberto —, instale o Ollama com pkg install ollama e prossiga os passos como mencionados anteriormente.